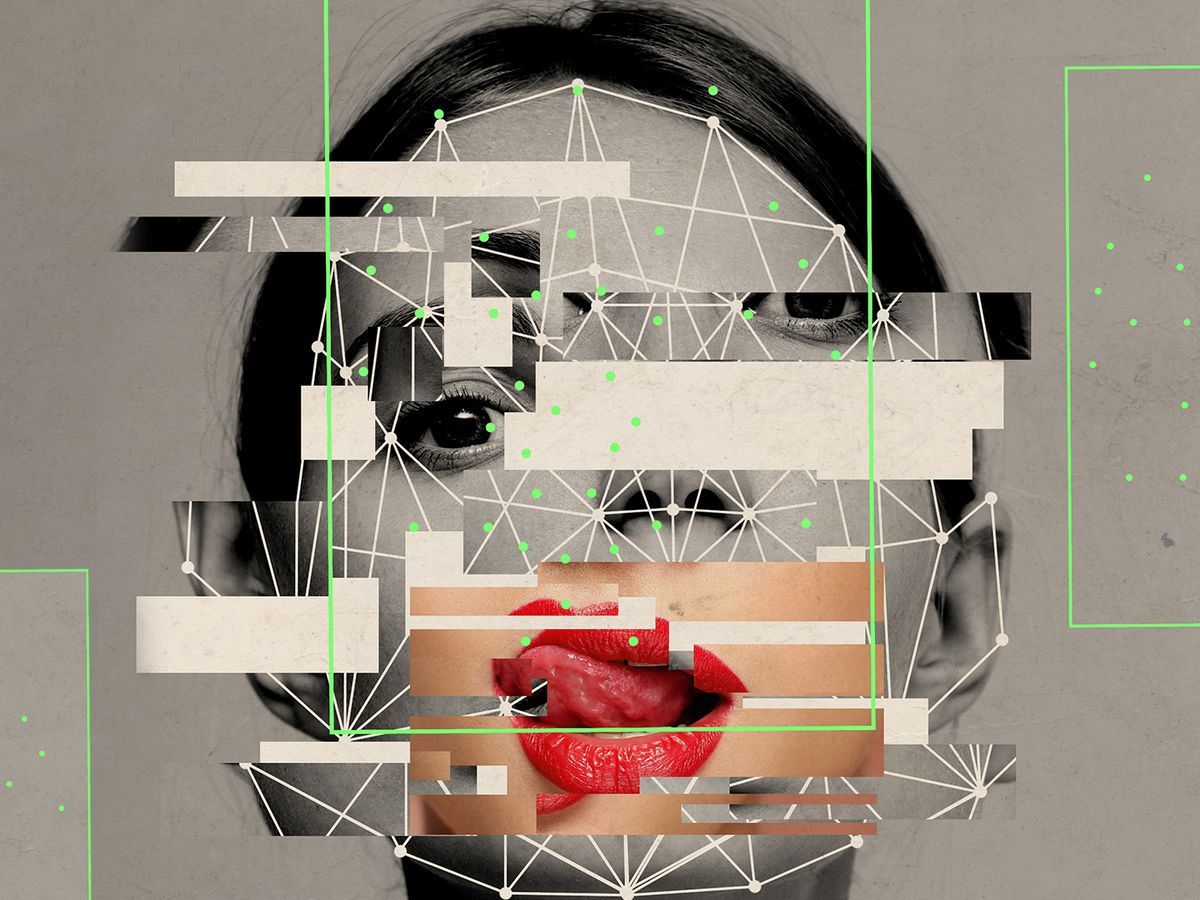

Terapist olarak ChatGPT'ye başvurmak artık birçok kişi tarafından denenen bir yöntem…

ABD’de ülke çapındaki ruhsal sağlık krizi ve terapist eksikliğinden kaynaklanan erişim eksikliği her geçen gün daha da büyüyen bir sorun ve acil olarak çözüme ihtiyacı var. Her sorunda olduğu gibi bu sorunda da ilk çözümün teknoloji olduğunu söyleyenler bulunuyor.

Üretken yapay zekâ sohbet robotları daha geniş bir kullanıcı kitlesine sunuldukça, bazı kişiler terapist olarak ChatGPT gibi hazır, çok amaçlı araçları kullanmaya başladı. Vice, bu yılın başlarında bu kullanıcılardan bazılarıyla konuştu ve insanların sohbet robotlarıyla ilgili deneyimlerini aktaran haberlerin sosyal medyada eskiye oranla daha fazla ortaya çıktığını belirtti. Hatta bir Reddit kullanıcısı, kullandığı chatbot'un ruhsal sağlık tavsiyesi sağlamaya yönelik eşiklerini nasıl aşacağınızı anlatan, botu doğru şekilde “eğitme” rehberi bile yazdı.

Ancak unutmamak gerekir ki ChatGPT kimsenin terapisti olacak şekilde tasarlanmadı. Gerçek terapistlerin uygulamalarına ve etik durumlara yön veren gizlilik veya sorumluluk ilkelerine de bağlı değil. Bir chatbot, örneğin bir araştırma makalesi için kaynak üretirken başarısız sonuçlar verse de bu büyük bir problem değil. Ancak ciddi bir akıl sağlığı sorunu olan birine tehlikeli veya yanlış tıbbi tavsiye sağlayan bir chatbot'un neden olabileceği zarar oldukça ciddi olabilir.

Yine de bu, yapay zekâ sistemlerinin ruhsal sağlık rehberi olarak işe yaramaz olduğu anlamına gelmiyor. Stanford İnsan Merkezli Yapay Zekâ Enstitüsü'nde psikolog ve araştırmacı olan Betsy Stade, herhangi bir yapay zeka ve terapi analizinin, bir tedaviyi değerlendirmek için psikolojide kullanılanla aynı ölçüt etrafında çerçevelenmesi gerektiğini söylüyor: “Hastanın iyileşmesini sağlıyor mu?”

Üretken yapay zekânın ruhsal sağlık hizmetlerine dahil edilmesine ilişkin bir makalenin baş yazarı olan Stade, yapay zekânın hastaların daha iyi sonuçlarla daha iyi bakım almasına yardımcı olabileceği konusunda iyimser görüşte olanlardan. Ancak bu bilgisayarınızda ChatGPT'yi açmak kadar basit değil.

"Yapay zeka terapisti" terimi birkaç farklı şeyi ifade etmek için kullanılıyor aslında. Birincisi, özellikle ruh sağlığı hizmetlerine yardımcı olmak için tasarlanmış, bazıları kamuya açık, bazıları ise halka açık olmayan özel uygulamaları tanımlıyor. Bu uygulamalar ChatGPT gibi araçlardan çok önce de mevcuttu aslında. Örneğin Woebot, bilişsel davranışçı terapiye dayalı yardım sağlamak üzere tasarlanmış, 2017'de açılan bir hizmetti ve Kovid salgını sırasında erişimi terapiden daha kolay ve ucuz olduğu için hayli popülerlik kazanmıştı.

Daha sonra ise ChatGPT'nin temelini oluşturan büyük dil modelleri sayesinde ücretsiz veya terapiden çok daha ucuza gelen sohbet robotları çoğaldı. Geçtiğimiz Ocak ayında, ruh sağlığı platformu KoKo'nun kurucu ortağı, gerçek bir insanla konuştuğunu sanan binlerce kullanıcıya yapay zekâ tarafından oluşturulan yanıtlar sağladığını duyurdu.

Sohbet robotları ve terapi hakkındaki incelemelerin, yapay zekânın bir terapi seansını taklit etmenin dışında ruhsal sağlık bakımından oynayabileceği rollere ilişkin araştırmalarla eş zamanlı gerçekleştiğini de belirtmekte fayda var. Örneğin yapay zekâ araçları, gerçek terapistlerin notlarını organize etme ve kanıtlanmış tedavi standartlarının korunmasını sağlama gibi konulara yardımcı olabilir; bu da hasta sonuçlarını iyileştirme konusunda kolaylık sağlar.

Terapi arayan bu kadar çok insanın neden yapay zekâ destekli sohbet robotlarına yöneldiğine dair birkaç hipotez var. Belki bu botlar sayesinde kolayca duygusal ya da sosyal destek buluyorlar. Ancak desteğin düzeyi muhtemelen kişiden kişiye farklılık gösteriyor ve kesinlikle ruhsal sağlık konusundaki gerçek ihtiyaçlarına, terapiye dair beklentilerine ve ayrıca bir uygulamanın onlara neler sağlayabileceğine göre değişik oranlarda fayda sağlıyor.

DEHB konusunda uzmanlaşmış klinik psikolog ve bu durumla başa çıkmaya çalışanlara yardımcı olmayı amaçlayan bir girişimin kurucu ortağı olan Lara Honos-Webb, terapinin farklı insanlar için pek çok farklı şey ifade ettiğini ve insanların terapistlere pek çok farklı nedenden dolayı geldiğini söylüyor.

ChatGPT'yi faydalı bulanların bu araçlara basitçe “sorun ve çözümü" düzeyinde yaklaşıyor olabileceğini söylüyor. Bu gibi araçlar, düşünceleri yeniden şekillendirmede veya denenecek sağlıklı aktivitelerin bir listesi gibi "davranışsal aktivasyon" sağlamada oldukça iyi sonuçlar veriyor gibi görünebilir. Ancak Stade, araştırma açısından bakıldığında uzmanların bu durumda insanların kendileri için neyin işe yaradığını düşündüklerini gerçekten bilmediklerini ekliyor: “Birkaç kişinin öznel deneyimleri hakkında Reddit'te karşılaştığımız paylaşımlar dışında, aslında chatbotlarla terapide olup bitenlere dair iyi bir incelemeye sahip değiliz.”

Bu konuda bazı bariz kaygılar var: Mesela gizlilik büyük bir sorun. Bu, üretken yapay zekâ araçlarının tedaviyi taklit etme konusunda daha iyi hâle getirilmesi için kullanılan eğitim verilerinin işlenmesinin yanı sıra, yardım isterken hassas tıbbi bilgileri bir chatbot'a açıklayan kullanıcıların gizliliğini de içeriyor. Aynı zamanda bu sistemlerin birçoğunun bugünkü hâliyle yerleşik önyargıları da var; bunlar genellikle toplumda halihazırda var olan daha büyük sistemik eşitsizlikleri yansıtıyor ve güçlendiriyor.

Ancak chatbot terapisinin en büyük riski -ister kötü tasarlanmış olsun, ister ruhsal sağlık için tasarlanmamış bir yazılım tarafından sağlansın- iyi destek ve bakım veremeyerek insanlara zarar verebilmesi. Çünkü terapi dediğimiz şey bir sohbet metninden ve bir dizi öneriden daha fazlasıdır. DEHB hakkında makaleler yazarken düşüncelerini düzenlemek için ChatGPT gibi üretken yapay zekâ araçlarını kullanan, ancak terapist olarak pratiği için asla kullanmayan Honos-Webb, terapistlerin yapay zekânın henüz yakalamaya hazır olmadığı birçok ipucu ve nüansı yakaladığını söylüyor.

Stade, makalesinde büyük dil modellerinin psikoterapi için gerekli bazı becerileri yürütme konusunda “umut verici” bir kapasiteye sahip olmasına rağmen, “terapi becerilerini simüle etmek” ile “onları etkili bir şekilde uygulamak” arasında bir fark olduğunu belirtiyor. Bu sistemlerin, intihar düşünceleri, madde bağımlılığı veya belirli yaşam olaylarını içeren karmaşık vakaları nasıl ele alabileceğine dair belirli endişelere dikkat çekiyor.

Honos-Webb, yakın zamanda yeme bozukluğu geliştiren yaşlı bir kadın hasta örneğini veriyor. Tedavinin bir düzeyi özellikle bu davranışa odaklanabilir: Birisi yemek yemiyorsa, yemesine ne yardımcı olabilir? Ancak iyi bir terapist bunların daha fazlasını anlayacaktır. Zamanla terapist ve hasta yakın zamandaki kimi olaylar arasında bağlantı kurabilir: Belki hastanın kocası yakın zamanda emekli olduğu için kendisinde bu bozukluk gelişmişti. Kızgın ve huzursuzdu çünkü kocası birdenbire sürekli evde olmaya başlamıştı ve onun yaşam alanını daha fazla işgal ediyordu.

Honos-Webb, “Terapinin büyük bir kısmı, ortaya çıkan bağlama, gördüklerinize, fark ettiklerinize duyarlı olmaktır” diye açıklıyor. “Ve bu çalışmanın etkililiği terapist ile hasta arasında gelişen ilişkiye doğrudan bağlıdır.”

Etik olarak uygulandığında yapay zekâ, insanların ruhsal sağlık bakımı ararken onlara yardımcı olacak değerli bir araç hâline gelebilir. Ancak Stade, bu krizin ardındaki nedenlerin teknoloji alanından çok daha geniş kapsamlı olduğunu ve yalnızca yeni bir uygulamadan ibaret olmayan bir çözüm gerektireceğini belirtiyor.

Stede'e ABD'deki ruh sağlığı hizmetlerine erişim krizini çözmede yapay zekânın rolü sorulduğunda ise şunları söylüyor: "Evrensel sağlık hizmetlerine ihtiyacımız olduğuna inanıyorum. Yapay zekâ alanının dışında gerçekleşmesi gereken çok şey var. Bununla birlikte bu araçların genişleme ve boşlukları doldurma konusunda bazı heyecan verici fırsatlara sahip olduğunu da düşünüyorum.”

Kaynak: Vox

Araştırmacılara göre fotoğraflarda kadınları soymak için yapay zekâ kullanan uygulama ve web sitelerinin popülaritesi artıyor. Sosyal ağ analiz şirketi Graphika'ya göre ya...

Şubat 2022’de başlayan Rusya’nın Ukrayna işgali, iki ülke arasında bitmek bilmeyen çatışmaları ve küresel krizi beraberinde getirdi. Ukrayna ve Rusya arasındaki savaşta Uk...